בראשית דרכו התבסס מנוע החיפוש של גוגל בעיקר על קישורים (PageRank). בהמשך הופיעו עדכונים כמו פנדה, שהדגיש איכות תוכן והתמודד עם תוכן משוכפל ועמודי ספאם; פינגווין, שנלחם בפרופילי קישורים לא טבעיים; האמינג-ברד, שהוסיף הבנה סמנטית והתייחסות לכוונת המשתמש; RankBrain, שהטמיע למידת מכונה לניתוח דפוסי חיפוש מורכבים; Core Web Vitals, שבחן ביצועים טכניים וחוויית משתמש; ולבסוף E-E-A-T, שהעלה את חשיבות הניסיון המעשי במתן מידע בתחומים רגישים. כך, גוגל עברה להתמקד בהיבטים רבים – מתוכן וקישורים ועד תפקוד טכני ואמינות – ומשתנה ללא הרף כדי להבטיח תוצאות חיפוש כמה שיותר רלוונטיות ואיכותיות.

ממהרים? הנה השאלות (והתשובות) המרכזיות במאמר

מכיוון שבשנותיו הראשונות גוגל התבסס על כמות ואיכות הקישורים כ”המלצות” לדרוג אתרי אינטרנט, מה שנקרא PageRank.

פנדה התמקד באיכות התוכן וביקש להעניש אתרים בעלי תוכן משוכפל, דל או מוצף פרסומות, תוך מתן עדיפות לאתרים איכותיים.

פינגווין התמקד באיכות הקישורים החיצוניים לאתר, ובפרט זיהה דפוסים של רשתות קישורים, פרופילי קישורים לא טבעיים וטקסט עוגן אחיד מדי.

האמינג-ברד עבר מגישה של “התאמת מילים” לגישה של “הבנת כוונת המשתמש” (Intent), מה שהעלה את חשיבות ההקשר הסמנטי בחיפוש.

RankBrain הכניס למידת מכונה (Machine Learning) לתוך מנוע החיפוש, כך שגוגל למדה לנתח דפוסי שאילתות מורכבים ולהבין טוב יותר מילים נרדפות ומשמעות רחבה.

Core Web Vitals מודד היבטים טכניים כמו מהירות הטעינה, אינטראקטיביות ויציבות הפריסה, כדי לשפר את חוויית המשתמש באתר.

גוגל מצפה כעת לראות לא רק מומחיות וסמכות, אלא גם ניסיון מעשי או אישי בתחומים רגישים (רפואה, פיננסים וכד’), מה שמגדיל את הדרישה לאמינות התוכן.

התפתחות ראשונית של האלגוריתם (1995–2000)

סיפורו של גוגל מתחיל עוד לפני רכישת הדומיין Google.com. באמצע שנות התשעים, לארי פייג' וסרגיי ברין – שעוד היו שני סטודנטים צעירים מאוניברסיטת סטנפורד – פיתחו מנוע חיפוש ניסיוני בשם “BackRub”. הרעיון שהנחה אותם היה חדשני במיוחד לתקופה: במקום להתמקד רק במילות מפתח שמופיעות בדפי אינטרנט, הם השתמשו בקישורים נכנסים (Backlinks) כמעין “הצבעות אמון”. אם אתר אחד מקשר לאתר אחר, משמע שהאתר המקושר מייצג, לכאורה, תוכן בעל ערך או רלוונטיות כלשהי.

בשנת 1997 רכשו פייג' וברין את הדומיין Google.com, והחלו לעצב את המבנה ואת העקרונות שינחו את מנוע החיפוש שלהם. המנוע התאפיין בעיצוב נקי ובהיר, בניגוד למתחרים אחרים, והציג את התוצאות באופן ממוקד. כבר בראשית דרכו, גוגל שאף “לסדר את המידע העולמי ולהפוך אותו לנגיש ושימושי”. זה אולי נשמע לנו טבעי כיום, אבל בסוף שנות התשעים זו הייתה תפיסת עולם חדשה, בפרט לאור העובדה שהאינטרנט עצמו עדיין היה צעיר יחסית.

בשנת 1998 הציגו פייג' וברין לראשונה את מנגנון PageRank: אלגוריתם שמדרג דפים לפי מספר הקישורים (Backlinks) והאיכות שלהם. אם אתר חשוב ומוכר מקשר לאתר אחר, גוגל מניחה שגם האתר האחר בעל ערך. כך נוצרה מערכת שמנסה להעריך איכות או “פופולריות” של דף אינטרנט בצורה אובייקטיבית.

פריצת הדרך הגדולה הגיעה בשנת 2000, כשגוגל השיקה את Google AdWords (כיום Google Ads) – פלטפורמת הפרסום הממומן שלה, שבה מפרסמים יכולים לרכוש מודעות שמופיעות לצד תוצאות החיפוש האורגניות. המהלך שילב מנוע חיפוש חינמי, המבוסס על אלגוריתם מתוחכם, עם מודל עסקי שיצר לגוגל הכנסות משמעותיות. באותה תקופה, תוצאות החיפוש כבר החלו להיות מדויקות ורלוונטיות בהשוואה למתחרים, מה שהקפיץ את גוגל לחזית עולם החיפוש.

צמיחת גוגל והולדת ה-Black Hat (2001–2004)

בתחילת שנות האלפיים, גוגל כבר התחיל לצבור פופולריות עצומה, בעיקר בזכות היעילות והפשטות שלו בהשוואה למנועי חיפוש אחרים כמו AltaVista או Yahoo! באותה עת, אנשים שגילו את הרעיון של PageRank הבינו שקישורים ממלאים תפקיד מרכזי בקביעת הדירוג. לצד העוסקים קידום אתרים אורגני איכותי, שהתמקדו ביצירת תוכן איכותי ובהשגת קישורים טבעיים, הופיעה קבוצה נמרצת של מקדמי אתרים שהחליטו “לתחמן” את המערכת – כך נולד Black Hat SEO.

האסטרטגיות של ה-Black Hat היו מגוונות:

- חוות קישורים (Link Farms): אתרים רבים שהוקמו כדי להחליף ביניהם קישורים, במטרה לשוות רושם שיש כאן אתרים מבוססים ופופולריים.

- Keyword Stuffing: הצפה של דפי האתר באותה מילת מפתח עשרות פעמים, לעיתים בצורה מוסתרת או בחלקים נסתרים של הדף.

- דפי Doorway: יצירת דפים שמטרתם היחידה היא לפתות את מנוע החיפוש להאמין שיש תוכן אמיתי, בעוד הגולש בפועל מנותב לעמוד אחר.

מאחר וגוגל עוד לא היה מצויד בכלים מתוחכמים לזיהוי התרגילים הללו, חלק מאותם אתרים נהנו מדירוגים גבוהים ותנועה משמעותית, אף על פי שהתוכן שלהם לא תמיד היה בעל ערך. התופעה יצרה אצל גוגל צורך דוחק למצוא פתרונות שיחזירו את איכות התוצאות למסלול.

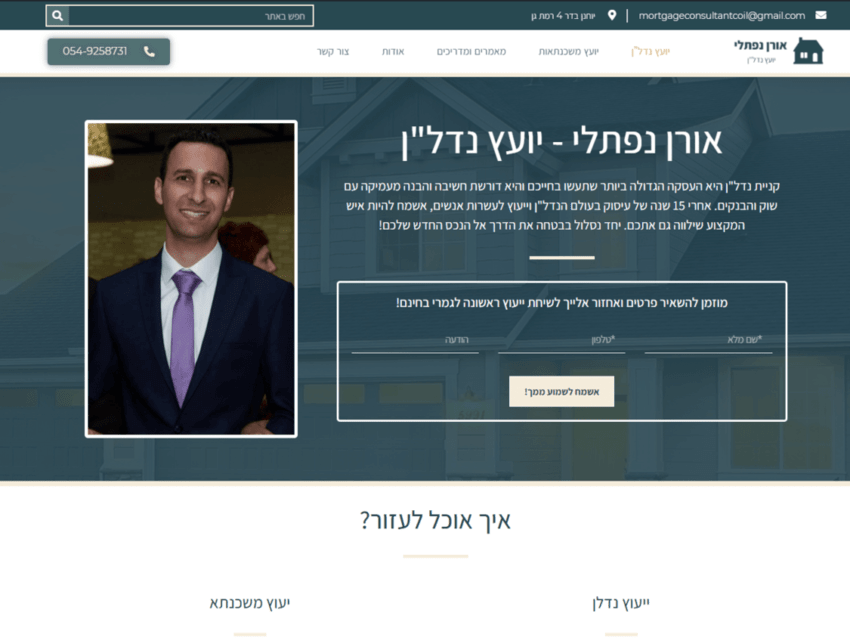

מתעניין בבנייה או קידום האתר שלך? מוזמן לשיחת ייעוץ ראשונית ללא עלות!

ניתן גם להשאיר פרטים בטופס הבא

התעצמות מנגנוני הפיקוח והשקת Webmaster Tools (2005–2009)

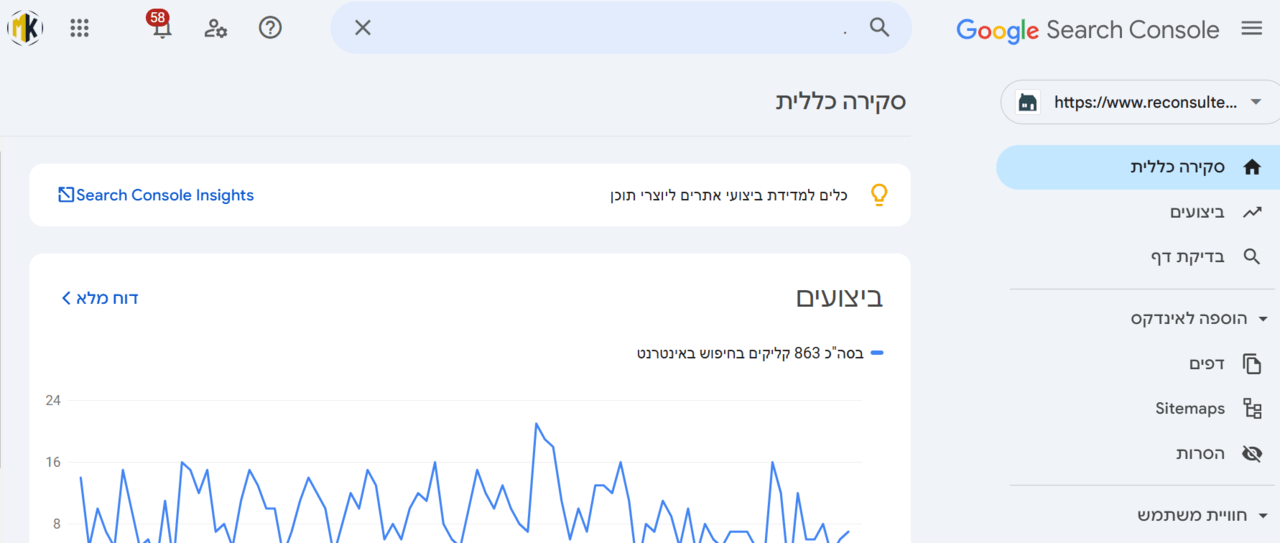

כדי להתמודד עם התופעות השליליות, גוגל נדרשה לפתח מנגנוני ביקורת יעילים יותר. בשנת 2005 הוציאה גוגל כלי בשם “Google Sitemaps”, שהיה הבסיס למה שנקרא בהמשך Google Webmaster Tools. הרעיון המקורי היה לאפשר לבעלי אתרים להגיש לגוגל מפת אתר (Sitemap) כדי להקל על סריקת הדפים. בהדרגה, נוספו לכלי יכולות מתקדמות, כמו דו"חות על שגיאות סריקה, התראות על עונשים ידניים (Manual Actions), וגם מידע על שאילתות מובילות שהביאו גולשים לאתר.

עד 2009, הכלי התרחב והתבסס כאמצעי חשוב שבעלי אתרים השתמשו בו כדי להבין איך גוגל “רואה” את האתר שלהם. עם זאת, גם כש-Webmaster Tools (לימים: Google Search Console) נהיה מקיף יותר, נותרו פרצות רבות למניפולציות Black Hat. לא מעט עסקים קטנים וגדולים כאחד ניסו להדביק את הקצב, ופנו למקדמי אתרים שהבטיחו “1000 קישורים בשבוע” או “מקום ראשון בגוגל תוך חודש”, בלי להשקיע בתוכן אמיתי או לחשוב על טובת הגולש.

עד 2010, נראה שגוגל מפסידה בקרב נגד ה-Black Hat: מספר רשתות הקישורים גדל, אתרים השתמשו בשיטות מפוקפקות כדי לפמפם לעצמם קישורים, וספאם מילות מפתח המשיך לשגשג. המצב יצר חוסר שביעות רצון גובר בקרב המשתמשים, שהחלו להיתקל בתוצאות חיפוש פחות רלוונטיות. בעיני גוגל, זו הייתה בעיה אסטרטגית: אם המשתמשים לא ימצאו מידע איכותי, הם יעברו למתחרים. ואם זה יקרה, גם מערך הפרסום הממומן (AdWords) יאבד מתקופתו.

על הרקע הזה, גוגל החלה להכין תשתיות לגל עדכונים אלגוריתמיים רחבי היקף. החברה הבינה שהיא זקוקה לפתרונות ממוקדים, שיענישו אתרים דלי תוכן וספאמיים וירוממו את אלה שבאמת נותנים ערך למשתמש. וכאן נכנסים לתמונה העדכונים המפורסמים כמו פנדה (Panda) ופינגווין (Penguin), ששינו את כללי המשחק בעולם ה-SEO.

עדכון פנדה (Panda, 2011)

ב-2011 השיקה גוגל את עדכון פנדה (Panda). העדכון קיבל את שמו מאחד המהנדסים של גוגל, נבין פנדה, שהיה מעורב בפיתוחו. הרעיון המרכזי היה להבחין בין אתרים עם תוכן איכותי ומקורי לבין אתרים עם תוכן משוכפל, דל או פשוט לא מועיל. אם עד אז ניתן היה “לפסה” במילות מפתח ולייצר עמודים ריקים כמעט, פנדה הגיע כדי להגיד: “עד כאן.” גוגל החלה לבחון יותר ויותר מדדים של אינטראקציית הגולש:

- כמה זמן המבקר נשאר בדף?

- האם הוא גולל וקרא?

- האם הוא הקליק על חלקים נוספים באתר?

בנוסף, פנדה התייחס גם למידת הפרסומות ביחס לתוכן. אתרים שהציגו כמות רבה של מודעות במקום תוכן ממשי קיבלו ציון איכות נמוך, ונפגעו בדירוג. הסדרה הראשונה של עדכוני פנדה (2011–2012) גרמה לזעזוע בענף הקידום: אתרים רבים שהיו “דלילים” בתוכן צנחו למטה, בעוד אתרים שהשקיעו בכתיבה מעמיקה ובערך אמיתי למשתמש זינקו למעלה.

עדכון פינגווין (Penguin, 2012)

כשנה לאחר השקת פנדה, הוצג עדכון פינגווין (Penguin) ב-2012. אם פנדה כיוון בעיקר לתוכן בעמודים, הרי שפינגווין התמקד בעולם הקישורים החיצוניים. האלגוריתם התחיל לזהות פרופילי קישורים חשודים, דוגמת:

- רשת אתרים על אותו שרת שמקשרים זה לזה בכמויות גדולות.

- חזרת מילות עוגן (Anchor Text) זהה בעשרות או מאות קישורים.

- קישורים מאתרי ספאם/פורנו/הימורים (שאינם קשורים לנושא).

המסר היה חד: אם ניהלתם אסטרטגיית קישורים אגרסיבית ומלאכותית, אתם מסתכנים בענישה. אתרים שנפגעו מעדכון פינגווין לעיתים קרובות חוו קריסה חדה בתנועה אורגנית, מה שגרם למקדמי אתרים רבים לערוך “ניקוי פרופיל קישורים” ולחפש דרכים לגיטימיות יותר לבנות מוניטין קישורי.

האמינג-ברד (Hummingbird, 2013) והבנת כוונת המשתמש

בשנת 2013 הגיעה גוגל לשלב הבא של ההתפתחות: עדכון האמינג-ברד (Hummingbird). בניגוד לפנדה ופינגווין, שנראו לעיתים כ"שכבות" נוספות על האלגוריתם, האמינג-ברד היה שינוי רחב בתשתית מנוע החיפוש. הפעם, גוגל שמה דגש לא רק על המילים שמוקלדות בשאילתה אלא על כוונת המשתמש.

אם בעבר, אלגוריתם היה סורק את הטקסט בדף ומחפש “התאמה” למילות המפתח, הרי שהאמינג-ברד ניסה להבין את ההקשר הרחב. כך, למשל, כשמישהו מקליד “קידום אתרים מחיר,” גוגל מבינה שהמשתמש רוצה לדעת עלויות, מסלולים ותעריפים, ולא רק עמוד שמופיעה בו המחרוזת הזו. בשילוב עם Knowledge Graph, מנגנון המנסה לייצר "מפה" של מושגים ויחסים ביניהם, האמינג-ברד הפך את החיפוש ליותר סמנטי ועשיר בניואנסים.

עדכון פיג'ון (Pigeon, 2014)

בשנת 2014, יצא עדכון נוסף בשם פיג'ון (Pigeon), שמיקד את תשומת הלב בתחום החיפושים הלוקאליים (Local Search). הרעיון המרכזי בעדכון פיג’ון היה להדק את הקשר בין מנוע החיפוש לבין התוצאות המקומיות, בדגש על Google Maps. משמעות העדכון: כשאדם מחפש “מסעדה איטלקית ליד הבית” או “אינסטלטור בחיפה,” גוגל שוקלת את המיקום הפיזי של המשתמש ואת הכתובת שבה העסק מופיע, ומתעדפת אתרים בעלי מיקום רלוונטי ואינפורמציה מקומית מלאה. כך, Google My Business הפך לכלי חשוב יותר, ובעלי עסקים למדו שכדאי לעדכן פרטי כתובת וטלפון, לצרף ביקורות של לקוחות ולוודא שהאזור הגאוגרפי מקבל ביטוי באתר.

מתעניין בבנייה או קידום האתר שלך? מוזמן לשיחת ייעוץ ראשונית ללא עלות!

ניתן גם להשאיר פרטים בטופס הבא

מובייל פרנדלי (Mobile Friendly, 2015) ו-Mobile First (2017–2018)

בשנת 2015, גוגל זיהתה שיותר ממחצית מהחיפושים נעשים מהסמארטפון. כך נולד העדכון המכונה לפעמים “Mobilegeddon,” שבו גוגל התחילה לתייג אתרים מותאמים לנייד (Mobile Friendly) מול כאלו שלא. אתרים שלא התאימו עצמם לגודל מסך קטן, לטקסט גדול מספיק ולכפתורים נגישים – החלו להידחק בדירוג בתוצאות החיפוש שמבוצעות במובייל.

בשנים 2017–2018, גוגל הרחיבה את הגישה הזו לתפיסת Mobile First: במקום לשפוט אתר קודם בגרסת הדסקטופ ולאחר מכן במובייל, עיקר האינדוקס והדירוג מתבסס על גרסת המובייל. למה? כי הרוב הגדול של הגולשים משתמשים בטלפון, ולכן גוגל מעוניינת להציג קודם כל את האתרים שמציעים חוויית גלישה מצוינת במובייל.

RankBrain (2015–2016) והחיבור לעולמות ה-AI

באותן שנים, 2015–2016, גוגל חשפה רכיב בשם RankBrain: שילוב למידת מכונה (Machine Learning) ובינה מלאכותית (AI) במנוע החיפוש. למעשה, גוגל החלה “ללמוד” דפוסים מתוך שאילתות שהוקלדו, לזהות מילים נרדפות ועומק סמנטי ולשפר את יכולתה להגיב לחיפושים מורכבים או נדירים. מטרת RankBrain לא הייתה להחליף לחלוטין את PageRank או את עדכוני פנדה ופינגווין, אלא להוסיף רובד חדש שמנסה “לנחש” מה המשתמש באמת מתכוון אליו גם אם הוא לא הקליד את הניסוח המדויק.

הדיון סביב RankBrain עסק רבות בשאלה האם זו “אינטליגנציה” במובן האנושי. בהיבט ה-SEO, המסר ברור: אי אפשר להסתפק באופטימיזציה טכנית או במשפטים טכניים. כדאי לספק תוכן מקיף שעונה על שאלות אמיתיות, וכתוצאה מכך – להתיישר עם הכוונה האמיתית שעומדת מאחורי החיפוש של המשתמש.

עדכון מדיק (Medic, 2018)

ב-2018 הופיע עדכון רחב שכונה בעגה המקצועית “Medic Update”, בעיקר משום שפגע במידה משמעותית באתרים רפואיים ובריאותיים. למעשה, הוא השפיע גם בתחומי YMYL (Your Money Your Life) נוספים, כמו פיננסים או משפטים – כלומר, נושאים רגישים לרווחת הגולש או לכספו. גוגל הדגישה יותר מתמיד את עקרונות E-A-T (Expertise, Authoritativeness, Trustworthiness) – מומחיות, סמכות ואמינות.

בעלי אתרים שנשענו על תוכן לא מספיק מוסמך בתחומים רגישים החלו לצנוח, בעוד אתרים עם אישורים מקצועיים, ציטוטים של מקורות רפואיים מוכרים או הסברים מפורטים זכו להישגים טובים יותר. העדכון הראה בבירור: בתחומים רגישים, גוגל דורשת רמה גבוהה יותר של אחריות, כתיבה מעמיקה ולפחות “חותמת” מומחית אחת שמראה שהמידע נבדק על ידי אדם בקיא.

Core Web Vitals (2020)

בשנת 2020, גוגל הלכה צעד נוסף לכיוון חוויית המשתמש, עם השקת Core Web Vitals. מדובר בשלושה מדדים טכניים עיקריים:

- LCP (Largest Contentful Paint): כמה מהר נטען התוכן העיקרי בדף.

- FID (First Input Delay): כמה זמן עובר מרגע שהדף מתחיל להיטען ועד שהגולש יכול לבצע פעולה אינטראקטיבית (למשל קליק).

- CLS (Cumulative Layout Shift): עד כמה האלמנטים בדף “קופצים” תוך כדי הטעינה.

בפרסומים של גוגל נאמר שמדדים אלה הופכים להיבט חשוב בדירוג, כיוון שאתרים שמציגים לגולש חוויית גלישה איטית, לא יציבה או מפוזרת עלולים לאכזב משתמשים ולגרום להם לצאת מהר. כך נוספה שכבה נוספת לתמונת ה-SEO: לא רק תוכן וקישורים, אלא גם מהירות הטעינה והנוחות הטכנית מקבלות משקל משמעותי.

מתעניין בבנייה או קידום האתר שלך? מוזמן לשיחת ייעוץ ראשונית ללא עלות!

ניתן גם להשאיר פרטים בטופס הבא

עדכון Helpful Content (שנת 2022)

בשנת 2022 הציגה גוגל את עדכון “Helpful Content Update”, שממשיך את הרעיון של פנדה בדגש על איכות כתיבת התוכן באתר, אך ממקד זאת ב”ערך המשתמש.” גוגל מבקשת לאתר עמודים ואתרים שנבנו בעיקר לטובת הקידום, ללא תוכן מועיל באמת או כזה החוזר על מידע טריוויאלי. עדכון זה, בשילוב יתר האלגוריתמים, בוחן האם העמוד אכן עונה על שאלת המשתמש ומספק מידע מועיל, או אם הוא סתם “מרפד” את עצמו בתוכן שטחי עבור מנוע החיפוש.

באופן כללי, אתרים שמציגים מידע תפל, מועתק, או שלא מוסיף שום דבר חדש – נמצאים בסיכון להיפגע. לעומתם, מי שמשקיע בכתיבה מעמיקה, תיקוף המקורות והוספת אלמנטים ייחודיים (כמו ניתוחים מקוריים, טבלאות, הדרכות מפורטות וכו’) אמור להפיק תועלת גם מהעדכון הזה.

מדיניות והנחיות E-E-A-T (2022)

אמנם E-A-T (Expertise, Authoritativeness, Trustworthiness) כבר היהמוכר כמה שנים, אבל בשלהי 2022 שדרגה גוגל את המושג ל-E-E-A-T, והוסיפה את האות E לייצג Experience (ניסיון). משמעות הדבר: גוגל מצפה לא רק למומחיות תיאורטית, אלא גם לניסיון מעשי או אישי בתחומים מסוימים, בעיקר בעולם ה-YMYL. כך, אם מישהו כותב על נושא רפואי, הגיוני שיראה רקורד, סיפור אישי או הכשרה מקצועית שמעניקים לו תוקף. במילים אחרות, גוגל שמה דגש כבד יותר על מידת הניסיון האמיתי שמאחורי כל כותב או אתר, ומשתמשת בכך כמדד נוסף לאמינות התוכן.

כאשר מביטים לאחור, מתברר שגוגל עברה מסע ארוך מאז ימי BackRub ו-PageRank בסוף שנות התשעים ועד לערכת העדכונים המתקדמת של ימינו (פנדה, פינגווין, האמינג-ברד, RankBrain, מובייל פירסט, מדיק, Core Web Vitals ועוד). אם בתחילה די היה להיעזר במילות מפתח ובכמה קישורים כדי להתקדם, הרי שבחלוף השנים גוגל שכללה את היכולת שלה להבחין בין תוכן איכותי ומועיל לבין תוכן “תחמני” או דל-ערך.

התמורות הללו משרתות את האינטרס של גוגל להציג למשתמשים את המידע הטוב ביותר, המהיר ביותר והאמין ביותר. האלגוריתם כבר אינו רק “מערכת לספירת קישורים,” אלא מנגנון מורכב שמסתכל על מבנה האתר (Core Web Vitals), על רמת כתיבת התוכן (פנדה, Helpful Content), על איכות הקישורים (פינגווין), על ההתאמה לכוונת המשתמש (האמינג-ברד, RankBrain) ועל נושאים שנוגעים לבריאות וכספים (Medic), ועכשיו גם על הניסיון המעשי שעומד מאחורי התוכן (E-E-A-T).

עבור בוני אתרים ומקדמי אתרים, הכלל ברור: כל מה שאינו נותן ערך מיידי ואמיתי לגולש – נמצא בסיכון להיפגע. הוסיפו לכך את העובדה שגוגל נותנת משקל לחוויית המשתמש (עם Core Web Vitals) ולנושא המובייל (Mobile Friendly, Mobile First), ותבינו שכל היבט באתר – החל מאיכות הכתיבה ועד המהירות והיציבות של התצוגה – הופך להיות חשוב.

יש לזכור שמנוע החיפוש של גוגל ממשיך להתעדכן כל הזמן, וככל שהבינה המלאכותית ולמידת המכונה מתפתחות, גוגל משכללת עוד יותר את היכולת שלה לזהות מניפולציות ולתגמל אתרים שנבנים סביב צורכי המשתמש. ההמלצה שלנו: השקיעו בתוכן אמיתי, הקפידו על קישורים טבעיים ואיכותיים, ודאגו לחוויית גלישה מושלמת בכל מכשיר. כך תישארו רלוונטיים גם בעידן של עדכונים תכופים ואלגוריתמים שהופכים חכמים מיום ליום.

בסופו של דבר, גוגל – כמו כל מערכת חיפוש – רוצה להגיש למשתמשים את מה שהם באמת מחפשים. אם נניח לנגד עינינו את המטרה הזו ביצירה, אופטימיזציה ותחזוקה של אתר, נוכל לנווט גם בשטפון העדכונים הבאים ולהישאר בצמרת.